L’arnaque par IA. Tout commence un matin par un message WhatsApp. Le numéro est inconnu, mais la photo de profil, le nom et le ton employé sont ceux du fondateur de mon entreprise. Il me sollicite pour une aide urgente et discrète sur un dossier confidentiel. Jusque-là, la situation semble plausible, voire banale dans un contexte professionnel agile.

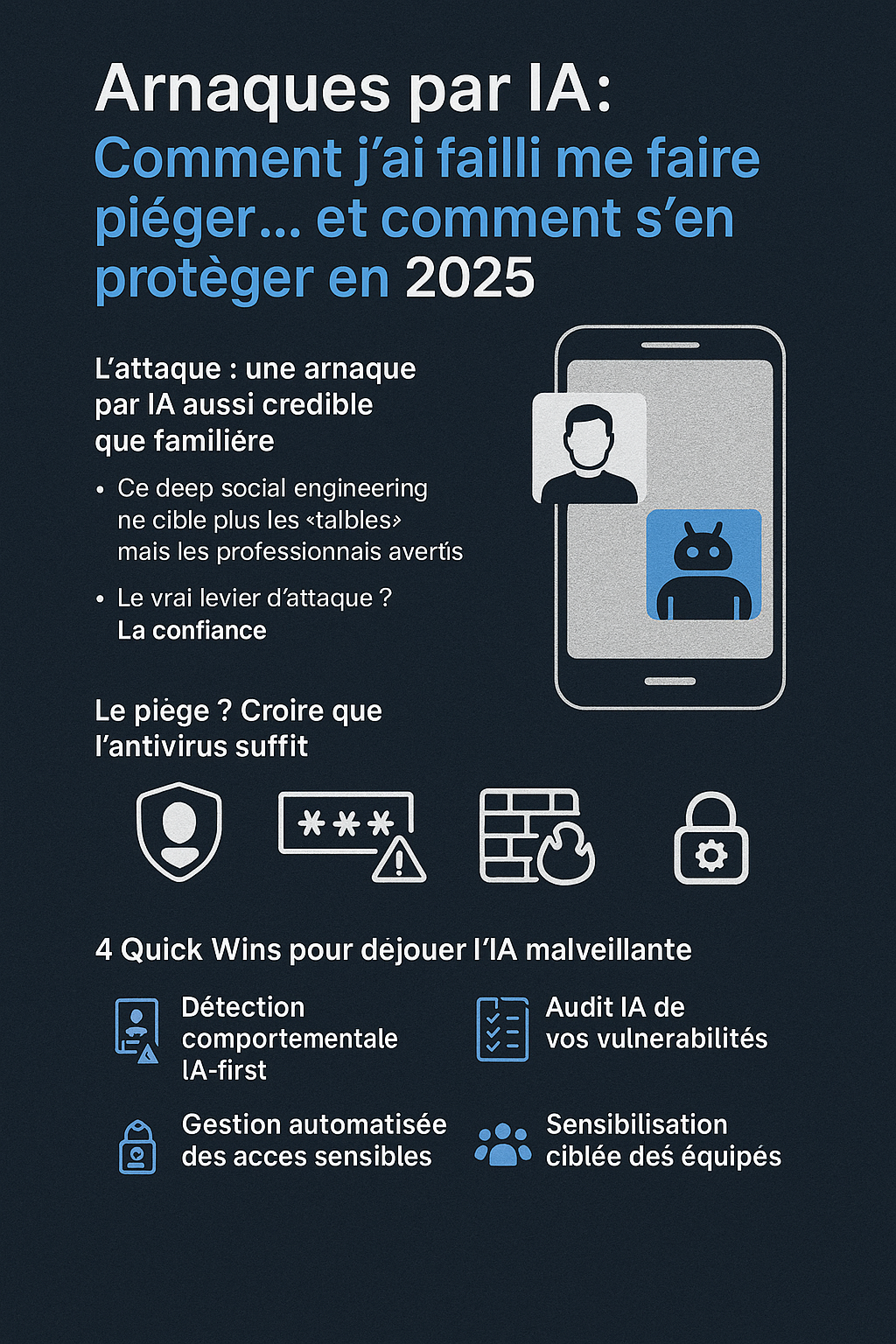

L’attaque : une arnaque par IA aussi crédible que familière

Rapidement, il m’oriente vers un prétendu avocat pour la signature d’un accord de confidentialité (NDA). Chaque interaction est crédible, chaque document semble légitime. Trop, peut-être.

Pourtant, un détail me met en alerte. Par réflexe, j’essaie de l’appeler directement. Aucune réponse. S’ensuivent des relances écrites, toujours cohérentes, rapides et parfaitement calibrées pour mettre la pression.

La réalité ? Ce n’était pas lui.

C’était une intelligence artificielle malveillante, nourrie de ses publications sur les réseaux sociaux, de nos échanges de mails passés, et de nos habitudes de langage. Une imitation parfaite, conçue pour exploiter la confiance.

Bienvenue dans l’ère du deep social engineering

En 2025, les arnaques les plus redoutables ne sont plus l’œuvre d’un simple hacker. Elles sont générées par des intelligences artificielles capables d’analyser et de reproduire avec une précision troublante :

- La manière d’écrire de vos collaborateurs.

- Les signatures de mail de vos partenaires.

- Les réflexes conversationnels de vos dirigeants.

Ce n’est plus le système informatique qui est la première cible, mais le facteur humain. L’attaque ne vise plus la faille technique, mais la confiance professionnelle.

Le piège : croire que la technologie seule suffit

Aujourd’hui, de nombreuses PME et organisations s’estiment protégées par un arsenal classique :

- Un antivirus performant.

- Des mots de passe complexes.

- Un pare-feu réseau.

C’est une illusion. Ces défenses sont indispensables, mais insuffisantes. Elles protègent le périmètre technique, mais sont aveugles à une menace qui ne « hacke » pas un mot de passe, mais qui imite une personnalité.

Notre méthodologie chez CriseHelp : une défense humaine et technologique

Face à cette menace invisible et autonome, une approche défensive centrée sur l’humain et soutenue par la bonne technologie est impérative. Voici les piliers sur lesquels nous construisons votre protection chez CriseHelp.

1. L’audit et l’anticipation des risques

Avant qu’une IA malveillante ne le fasse, nous identifions vos points de vulnérabilité. Un audit mené par nos experts permet de cartographier les risques liés aux usages et aux accès. Pour cela, nous nous appuyons sur des outils d’analyse comme Tenable ou Qualys, non pas comme une finalité, mais comme un point de départ pour une stratégie globale.

2. La détection comportementale anormale

Puisque les identifiants peuvent être légitimes, il faut analyser les comportements. Une demande de virement inhabituelle, une connexion depuis un lieu anormal, une consultation de fichiers en dehors des heures de travail… Des solutions comme Microsoft Defender for Business, couplées à une supervision humaine experte, permettent de détecter ces signaux faibles avant qu’ils ne deviennent critiques.

3. La résilience par la formation humaine

Chez CriseHelp, nous sommes convaincus que votre collaborateur est votre meilleur pare-feu contre l’arnaque par IA. Un employé formé à reconnaître les nouvelles techniques de manipulation psychologique devient un maillon fort. Nous ne nous contentons pas de formations génériques. Nous organisons des simulations d’attaques par IA (phishing vocal, usurpation par mail) et des ateliers pratiques pour transformer la méfiance en compétence.

4. La rationalisation des accès sensibles

Moins il y a de portes, moins il y a de risques. Nous vous aidons à mettre en place une gestion des accès critiques (mots de passe, comptes administrateurs) qui réduit la dépendance humaine et automatise la sécurité. Des outils comme 1Password Business peuvent être une composante de cette stratégie, en y ajoutant une couche de surveillance des comportements.

Face à l’IA, l’expertise humaine fait la différence

La menace a changé. Elle ne se cache plus derrière un code suspect, elle porte le visage de vos collaborateurs. Elle parle comme vous, pense comme vous, et agit plus vite que vous.

Dans cette nouvelle ère, la seule réponse efficace est une alliance entre l’intelligence humaine et la technologie. L’anticipation, la formation ciblée et l’accompagnement par des experts qui comprennent les deux facettes de cette menace sont la clé de votre sérénité.

Votre entreprise est-elle vraiment prête à faire face à une arnaque par IA?

- Avez-vous un protocole clair en cas de demande financière ou de partage d’informations sensibles par un canal de communication inhabituel ?

- Vos équipes sont-elles formées à reconnaître une tentative de manipulation psychologique, même si elle semble venir d’un supérieur hiérarchique ?

- Votre stratégie de cybersécurité prend-elle en compte l’analyse comportementale au-delà des simples antivirus ?

Si une seule de ces questions vous fait douter, il est temps d’agir.

L’équipe de CriseHelp est à votre disposition pour réaliser un diagnostic et bâtir avec vous une stratégie de défense sur-mesure. Contactez-nous sur crisehelp.fr

Nous sommes à votre écoute pour préciser votre besoin de préparation face à une arnaque par IA.

Nos experts et consultants indépendants sont en mesure de vous accompagner de A à Z dans l’évaluation de vos risques pour anticiper les crises.